Las gafas inteligentes Ray Ban de Meta ahora pueden ofrecer consejos de moda – Día Mundial del Agua

Los últimos Ray-Ban ya ofrecen algunas funciones limitadas de Meta AI, como tomar una foto usando la voz. Pero ahora Meta está ampliando significativamente el alcance de lo que puede hacer su nuevo robot: el martes, la compañía anunció que está probando una nueva función de inteligencia artificial «multimodal» que puede reconocer objetos vistos a través de gafas inteligentes, escuchar solicitudes y responder preguntas relevantes. preguntas sobre ellos, desde identificar alimentos hasta ofrecer orientación sobre estilo.

La clave de esta experiencia de “acceso temprano” es el sistema de cámara orientada hacia afuera en las monturas de las gafas. Los Ray-Ban no vienen con los potentes chips procesadores incluidos, por ejemplo, en los últimos iPhones y teléfonos inteligentes Pixel, por lo que no pueden realizar cálculos ni procesamiento integrados. Meta AI debe enviar las solicitudes e imágenes a los servidores de la empresa para su procesamiento antes de que las gafas puedan responder. Esto puede provocar un retraso de unos segundos, aunque el equipo de ingeniería está trabajando activamente para reducirlo.

Cuando el usuario pronuncia una consulta o comando en voz alta, el dispositivo captura y transmite imágenes de lo que ve a los servidores de la empresa, de modo que Meta AI pueda comprender lo que el usuario está mirando y brindar una respuesta relevante. Es como poner Google Lens en un par de Amazon Echo Frames.

En una demostración para WWD, las gafas apuntaban a una blusa con estampado multicolor y se le preguntó al robot: «Hola Meta, mira y dime qué va con esa blusa». Meta AI sugirió pantalones oscuros para resaltar el estampado. Para unos botines de piel negros con tachuelas, el técnico recomendó combinarlos con jeans. Pero no puede especificar un par de jeans en particular ni buscar tiendas que vendan esa bota específica, como puede hacer Google Lens. Al menos no todavía.

“A veces escucharás esto en un mensaje de error; Cuando pruebes esto en acceso anticipado, escucharás: ‘Lo siento, no puedo responder preguntas sobre el producto, pero estoy trabajando para obtener esta función pronto’”, Anant Narayanan, director de ingeniería de gafas inteligentes de Meta. , dijo a WWD. “Sabemos que debemos hacer un trabajo más específico para hacerlo bien. Pero por ahora, en la etapa de acceso temprano, las preguntas más genéricas son «¿qué va bien con esto?».

Según Narayanan, la espera puede no ser larga ya que el equipo pretende ofrecer habilidades centradas en el producto el próximo año. Esto no debería sorprender a nadie. Meta AI se ha ido extendiendo por el portafolio de dispositivos y redes sociales de la compañía, y el comercio social está en camino de convertirse en un negocio de mil millones de dólares este año. Statista estima que las ventas globales en 2023 en Instagram, Facebook y otras plataformas totalizarán alrededor de 1.300 millones de dólares para finales de año. Esto podría aumentar aún más en 2024 gracias a la última asociación de Meta con Amazon. El gigante del comercio electrónico ha llegado a acuerdos para integrar más directamente su plataforma de compras con las redes sociales.

Mientras tanto, los evaluadores tienen una serie de preguntas y comandos de Meta AI para probar. Todas las frases desencadenantes iniciales comienzan de la misma manera, con “Hola Meta, mira y…”, como en “Hola Meta, mira y dime qué recetas puedo hacer con estos ingredientes” o “Hola Meta, mira y resume este artículo para mí”. «. Una vez activado, el bot recuerda el contexto, por lo que puede comprender comandos de seguimiento más cortos sin la necesidad de repetir «mirar» cada vez. También puede responder preguntas cuando el usuario señala una palabra o frase específica en un documento de texto, menú de restaurante o artículo del Día Mundial del Agua, y ofrecer traducciones de idiomas sobre la marcha.

En la demostración, el robot identificó productos alimenticios, recomendó recetas que utilizan ingredientes específicos, leyó los menús de los restaurantes para resaltar platos picantes o vegetarianos e incluso creó una descripción humorística de las obras de arte instaladas en el vestíbulo a pedido. Algunos comandos funcionaron mejor que otros. En un caso, Meta AI identificó erróneamente una fruta del dragón como una granada, probablemente debido a la capacidad del robot para mantener el contexto. La peculiaridad desapareció cuando se borró la historia.

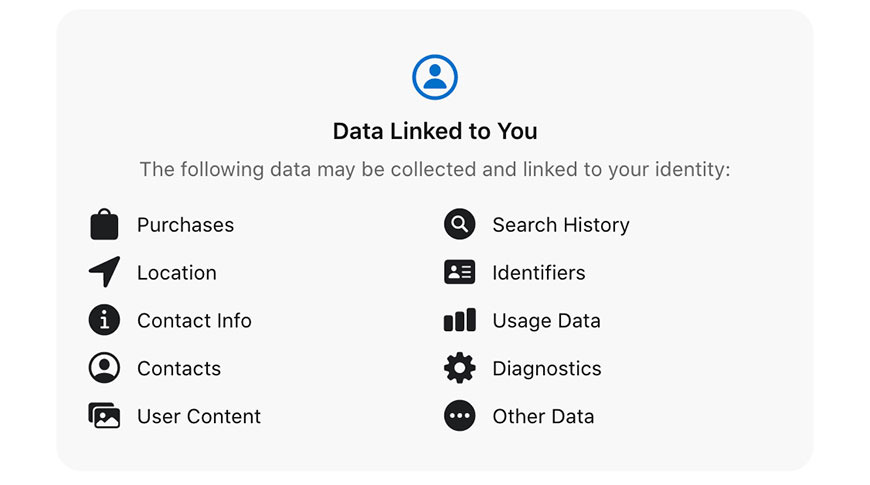

La capacidad del usuario para eliminar el historial y las imágenes de la IA es parte del esfuerzo de privacidad declarado de la compañía, lo cual tiene sentido considerando las críticas de larga data sobre la privacidad y las complicaciones legales que han afectado a Meta. También es una prioridad en la forma en que se ha desarrollado la IA. La herramienta fue entrenada con una combinación de datos recopilados específicamente por Meta o seleccionados de su familia de aplicaciones, pero en el último caso solo cuando los usuarios otorgaron permiso para que sus datos se usaran de esa manera, dijo Narayanan a WWD.

Naturalmente, como característica de prueba, la nueva funcionalidad Meta AI no es perfecta. Pero sigue siendo emocionante para los desarrolladores detrás de escena. Están ansiosos por ver cómo los evaluadores usan el bot y analizar los comentarios para mejorar. Esta entrada del usuario viene en un formato muy similar al de Facebook, con un sistema de calificación positiva o negativa para cada interacción guardada en la aplicación Meta View.

Meta AI se presentó por primera vez en Meta Connect en septiembre y desde entonces el bot se ha extendido a los auriculares Quest 3 y a las aplicaciones de Instagram, WhatsApp y Messenger, así como a las gafas Ray-Ban más nuevas. En el camino, el director ejecutivo Mark Zuckerberg ha estado dando al público vislumbres de lo que está por venir. En una publicación de Instagram de octubre, “Zuck” se maravilló de su nueva habilidad para trenzar el cabello de su hija con un video que decía: “Finalmente aprendí a trenzar. Gracias, Meta AI”.

El acceso anticipado a esta última función estará abierto a evaluadores seleccionados de un grupo de usuarios de EE. UU. que registren su interés en línea. Andrew “Boz” Bosworth, diretor de tecnologia da Meta, compartilhou a notícia no Instagram e outras mídias sociais na terça-feira: “Estamos testando IA multimodal em beta em óculos Ray-Ban Meta por meio de um programa de acesso antecipado opcional (somente en EUA) . Es pronto, pero estoy entusiasmado con cómo esto permitirá que Meta AI sea cada vez más útil, especialmente en formato de gafas”. Meta también está lanzando la capacidad para que los usuarios de Ray-Ban de EE. UU. soliciten información en tiempo real de Meta AI, con búsquedas impulsadas en parte por Bing.

La publicación del video de Zuckerberg en Instagram destacó el aspecto del estilo. El director general, probablemente con gafas, levantó una camisa marrón con rayas multicolores y dijo: “Oye, Meta, mira y dime qué pantalones usar con esta camisa”.

Meta AI respondió: “Según la imagen, parece ser una camisa a rayas. Un par de jeans oscuros o pantalones de color sólido complementarían bien esta camisa”.

![El iPhone 15 puede localizar a tus amigos hasta a 60 metros de distancia con Precision Finding [Video] El iPhone 15 puede localizar a tus amigos hasta a 60 metros de distancia con Precision Finding [Video]](https://i0.wp.com/9to5mac.com/wp-content/uploads/sites/6/2023/09/iphone-15-precision-finding.jpg?resize=1200,628&quality=82&strip=all&ssl=1)