Investigadores mejoran la visión periférica en modelos de IA | Noticias del MIT

La visión periférica permite a los humanos ver formas que no están directamente en nuestra línea de visión, aunque con menos detalle. Esta capacidad amplía nuestro campo de visión y puede ser útil en muchas situaciones, como por ejemplo detectar un vehículo que se acerca a nuestro coche por el lateral.

A diferencia de los humanos, la IA no tiene visión periférica. Equipar modelos de visión por computadora con esta capacidad podría ayudarlos a detectar peligros que se aproximan de manera más efectiva o predecir si un conductor humano notaría un objeto que se acerca.

Dando un paso en esta dirección, los investigadores del MIT han desarrollado un conjunto de datos de imágenes que les permite simular la visión periférica en modelos de aprendizaje automático. Descubrieron que entrenar modelos con este conjunto de datos mejoraba la capacidad de los modelos para detectar objetos en la periferia visual, aunque los modelos aún funcionaban peor que los humanos.

Los resultados también revelaron que, a diferencia de los humanos, ni el tamaño de los objetos ni la cantidad de desorden visual en una escena tuvieron un fuerte impacto en el rendimiento de la IA.

“Aquí está sucediendo algo fundamental. Probamos muchos modelos diferentes, e incluso cuando los entrenamos, mejoran un poco, pero no son exactamente como los humanos. Entonces la pregunta es: ¿qué les falta a estos modelos?” dice Vasha DuTell, becaria postdoctoral y coautora de un artículo que detalla este estudio.

Responder a esta pregunta podría ayudar a los investigadores a construir modelos de aprendizaje automático que puedan ver el mundo de forma más parecida a como lo ven los humanos. Además de mejorar la seguridad del conductor, estos modelos podrían usarse para desarrollar pantallas que sean más fáciles de ver para las personas.

Además, una comprensión más profunda de la visión periférica en los modelos de IA podría ayudar a los investigadores a predecir mejor el comportamiento humano, añade la autora principal Anne Harrington MEng '23.

“Modelar la visión periférica, si realmente podemos captar la esencia de lo que se representa en la periferia, puede ayudarnos a comprender las características de una escena visual que hacen que nuestros ojos se muevan para recopilar más información”, explica.

Sus coautores incluyen a Mark Hamilton, estudiante de posgrado en ingeniería eléctrica e informática; Ayush Tewari, becario postdoctoral; Simon Stent, director de investigación del Instituto de Investigación Toyota; y los autores principales William T. Freeman, profesor Thomas y Gerd Perkins de Ingeniería Eléctrica e Informática y miembro del Laboratorio de Informática e Inteligencia Artificial (CSAIL); y Ruth Rosenholtz, investigadora principal del Departamento de Ciencias Cognitivas y del Cerebro y miembro del CSAIL. La investigación se presentará en la Conferencia Internacional sobre Representaciones del Aprendizaje.

“Siempre que un ser humano interactúa con una máquina (un automóvil, un robot, una interfaz de usuario) es extremadamente importante comprender lo que la persona puede ver. La visión periférica desempeña un papel fundamental en esta comprensión”, afirma Rosenholtz.

Simulando la visión periférica

Extienda el brazo frente a usted y coloque el pulgar hacia arriba; la pequeña área alrededor de la uña del pulgar se ve a través de la fóvea, la pequeña depresión en el medio de la retina que proporciona la visión más nítida. Todo lo demás que puedes ver está en tu periferia visual. Su corteza visual representa una escena con menos detalles y confiabilidad a medida que se aleja de ese punto de enfoque nítido.

Muchos enfoques existentes para modelar la visión periférica en IA explican este deterioro del detalle al difuminar los bordes de las imágenes, pero la pérdida de información que ocurre en el nervio óptico y la corteza visual es mucho más compleja.

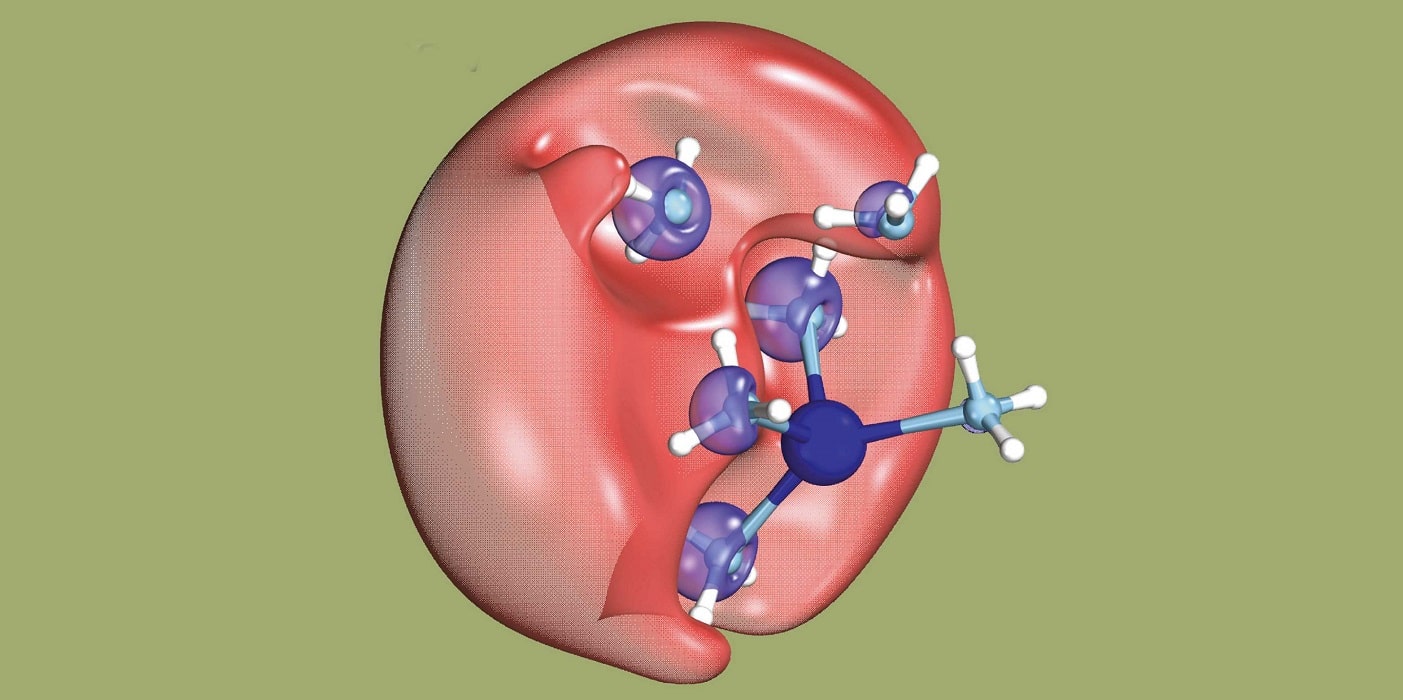

Para lograr un enfoque más preciso, los investigadores del MIT comenzaron con una técnica utilizada para modelar la visión periférica en humanos. Conocido como modelo de textura en mosaico, este método transforma imágenes para representar la pérdida de información visual de un ser humano.

Modificaron este modelo para que pudiera transformar imágenes de forma similar, pero de una forma más flexible que no requiere saber de antemano hacia dónde apuntará la persona o la IA.

«Esto nos permitió modelar fielmente la visión periférica de la misma manera que se hace en la investigación de la visión humana», dice Harrington.

Los investigadores utilizaron esta técnica modificada para generar un enorme conjunto de datos de imágenes transformadas que parecen más texturizadas en ciertas áreas, para representar la pérdida de detalle que ocurre cuando un humano mira más hacia la periferia.

Luego utilizaron el conjunto de datos para entrenar varios modelos de visión por computadora y compararon su desempeño con el de los humanos en una tarea de detección de objetos.

“Tuvimos que ser muy inteligentes a la hora de configurar el experimento para poder probarlo también en los modelos de aprendizaje automático. No queríamos tener que volver a entrenar a los modelos en una tarea de juguete que se suponía que no debían hacer”, dice.

Rendimiento peculiar

A los humanos y a los modelos se les mostraron pares de imágenes transformadas que eran idénticas excepto que una imagen tenía un objeto objetivo ubicado en la periferia. Luego, se pidió a cada participante que eligiera la imagen con el objeto objetivo.

“Una cosa que realmente nos sorprendió fue lo buena que era la gente para detectar objetos en su periferia. Revisamos al menos 10 conjuntos diferentes de imágenes que fueron muy fáciles. Seguimos necesitando utilizar objetos cada vez más pequeños”, añade Harrington.

Los investigadores descubrieron que entrenar modelos desde cero con su conjunto de datos conducía a mayores aumentos de rendimiento, mejorando su capacidad para detectar y reconocer objetos. El ajuste de un modelo con su conjunto de datos, un proceso que implica ajustar un modelo previamente entrenado para que pueda realizar una nueva tarea, dio como resultado menores ganancias de rendimiento.

Pero en todos los casos, las máquinas no eran tan buenas como los humanos y eran especialmente malas para detectar objetos en la periferia. Su desempeño tampoco siguió los mismos estándares que los humanos.

“Esto puede sugerir que los modelos no utilizan el contexto de la misma manera que los humanos hacen estas tareas de detección. La estrategia de los modelos puede ser diferente”, afirma Harrington.

Los investigadores planean seguir explorando estas diferencias, con el objetivo de encontrar un modelo que pueda predecir el desempeño humano en la periferia visual. Esto podría habilitar sistemas de inteligencia artificial que alerten a los conductores sobre peligros que tal vez no vean, por ejemplo. También esperan inspirar a otros investigadores a realizar estudios adicionales de visión por computadora con su conjunto de datos disponible públicamente.

“Este trabajo es importante porque contribuye a nuestra comprensión de que la visión humana en la periferia no debe considerarse simplemente una visión empobrecida debido a los límites en la cantidad de fotorreceptores que tenemos, sino más bien una representación optimizada para realizar tareas reales: una consecuencia global. «, dice Justin Gardner, profesor asociado del Departamento de Psicología de la Universidad de Stanford que no participó en este trabajo. “Además, el trabajo muestra que los modelos de redes neuronales, a pesar de su avance en los últimos años, no pueden igualar el desempeño humano en este aspecto, lo que debería conducir a más investigaciones sobre IA para aprender de la neurociencia de la visión humana. Esta investigación futura se verá significativamente favorecida por la base de datos de imágenes proporcionada por los autores para imitar la visión periférica humana”.

Este trabajo cuenta con el apoyo, en parte, del Toyota Research Institute y la beca MIT CSAIL METEOR.