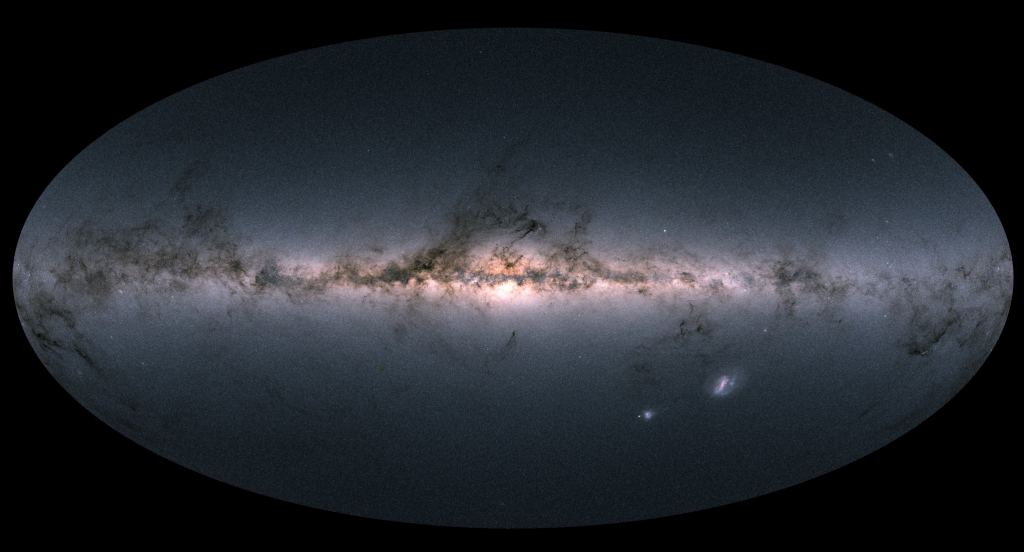

Hay 6×10 ^ 80 bits de información en el universo observable.

Desde el comienzo de la era digital (alrededor de 1970), los físicos teóricos han estado especulando sobre la posible conexión entre la información y el Universo físico. Dado que toda la materia está compuesta de información que describe el estado de un sistema cuántico (también conocido como información cuántica), y la información genética está codificada en nuestro ADN, no es descabellado pensar que la realidad física se puede expresar en términos de datos. .

Esto condujo a muchos experimentos mentales y paradojas, en los que los investigadores intentaron estimar la capacidad de información del cosmos. En un estudio reciente, el Dr. Melvin M. Vopson, matemático y profesor principal de Universidad de Portsmouth – ofreció nuevas estimaciones de cuánta información está codificada en toda la materia bariónica (también conocida como materia común o «luminosa») en el Universo.

El estudio que describe los resultados de su investigación apareció recientemente en la revista científica AIP Advances, una publicación mantenida por Instituto Americano de Física (AIP). Aunque se han realizado estimaciones anteriores sobre la cantidad de información codificada en el Universo, Vopson es el primero en confiar en la Teoría de la Información (TI), un campo de estudio que se ocupa de la transmisión, procesamiento, extracción y uso de la información.

Este enfoque innovador le permitió abordar los problemas que surgen de la TI, a saber: «¿Por qué hay información almacenada en el universo y dónde está?» y «¿Cuánta información se almacena en el universo?» Como explicó Vopson en un reciente Comunicado de prensa de AIP:

“La capacidad de información del universo ha sido un tema de debate durante más de medio siglo. Ha habido varios intentos de estimar el contenido de información del universo, pero en este artículo, describo un enfoque único que postula además cuánta información se puede comprimir en una sola partícula elemental. «

Aunque una investigación similar ha investigado la posibilidad de que la información sea física y pueda medirse, el significado físico preciso de esta relación sigue siendo difícil de alcanzar. Con la esperanza de resolver este problema, Vopson se basó en el trabajo del famoso matemático, ingeniero eléctrico y criptógrafo Claude Shannon, llamado el «padre de la era digital» debido a su trabajo pionero en la teoría de la información.

Shannon definió su método para cuantificar la información en un artículo de 1948 titulado “Una teoría matemática de la comunicación, ”Lo que resultó en la adopción del“ bit ”(un término introducido por Shannon) como unidad de medida. Esta no es la primera vez que Vopson invierte en TI y en datos codificados físicamente. Anteriormente, discutió cómo se puede extrapolar la naturaleza física de la información para producir estimaciones sobre la masa de datos en sí.

Esto fue descrito en su artículo de 2019, “O información-masa-energía principio de equivalencia, “Eso amplía las teorías de Einstein sobre la interrelación de la materia y la energía con los datos mismos. De acuerdo con TI, el estudio de Vopson se basó en el principio de que la información es física y que todos los sistemas físicos pueden registrar información. Concluyó que la masa de un bit individual de información a temperatura ambiente (-300K) es 3,19 × 10-38 kg (8.598 x 10-38 libras).

Llevando más allá el método de Shannon, Vopson determinó que cada partícula elemental en el universo observable tiene el equivalente a 1.509 bits de información codificada. «Es la primera vez que se utiliza este enfoque para medir el contenido de información del universo y proporciona una predicción numérica clara», dijo. «Incluso si no es del todo precisa, la predicción numérica ofrece una vía potencial para las pruebas experimentales».

Primero, Vopson empleó el conocido número de Eddington, que se refiere al número total de protones en el Universo observable (las estimaciones actuales lo sitúan en 1080) A partir de esto, Vopson derivó una fórmula para obtener el número de todas las partículas elementales del cosmos. Luego ajustó sus estimaciones de cuánto contendría cada partícula en función de la temperatura de la materia observable (estrellas, planetas, medio interestelar, etc.)

A partir de esto, Vopson calculó que la cantidad total de información codificada es equivalente a 6 × 1080 bits. Para decirlo en términos computacionales, estos muchos bits equivalen a 7.5 × 1059 zettabytes o zetabytes de 7,5 octodecillones. Compare eso con la cantidad de datos que se produjeron en todo el mundo durante el año 2020: 64,2 zetabytes. No hace falta decir que esta diferencia solo puede describirse como «astronómica».

Estos resultados se basan en estudios previos de Vopson, quien postuló que la información es el quinto estado de la materia (junto con el sólido, el líquido, el gas y el plasma) y que la materia oscura en sí misma puede ser información. También son consistentes con muchas investigaciones en los últimos años, todas las cuales han intentado arrojar luz sobre cómo interactúan la información y las leyes de la física.

Esto incluye cómo la información sale de un agujero negro, conocida como la “paradoja de la información del agujero negro”, y surge del hecho de que los agujeros negros emiten radiación. Esto significa que los agujeros negros pierden masa con el tiempo y no preservan la información de la materia que cae (como se creía anteriormente). Ambos descubrimientos se atribuyen a Stephen Hawking, el primero en descubrir este fenómeno, acertadamente llamado “Radiación de Hawking. »

También plantea la teoría holográfica, un principio de la teoría de cuerdas y la gravedad cuántica que especula que la realidad física surge de la información, como un holograma surge de un proyector. Y existe la interpretación más radical de esto, conocida como Teoría de la Simulación, que postula que todo el Universo es una simulación gigante por computadora, quizás creada por una especie muy avanzada para mantenernos a todos contenidos (generalmente conocido como “Hipótesis del planetario. «)

Como era de esperar, esta teoría presenta algunos problemas, como cómo la antimateria y los neutrinos encajan en la ecuación. También hace ciertas suposiciones sobre cómo se transfiere y almacena la información en nuestro Universo para obtener valores concretos. Sin embargo, ofrece una forma muy innovadora y completamente nueva de estimar el contenido de información del Universo, desde las partículas elementales hasta la materia visible en su conjunto.

Junto con las teorías de Vopson sobre la información que constituye el primer estado de la materia (o la materia oscura en sí), esta investigación proporciona una base que los estudios futuros pueden construir, probar y falsificar. Además, las implicaciones a largo plazo de esta investigación incluyen una posible explicación de la gravedad cuántica y la resolución de varias paradojas.

Otras lecturas: AIP, Anticipos de AIP

![Explorando la Tierra desde el espacio: ciudad-isla-nación de Singapur [Video] Explorando la Tierra desde el espacio: ciudad-isla-nación de Singapur [Video]](https://scitechdaily.com/images/Singapore-From-Space-scaled.jpg)