El enfoque práctico de Apple para la IA: sin fanfarronear, solo características

- El lunes en la WWDC, Apple reveló sutilmente cuánto trabajo está haciendo en inteligencia artificial y aprendizaje automático de próxima generación.

- A diferencia de la mayoría de las empresas tecnológicas que utilizan IA, Apple realiza un procesamiento sofisticado en sus dispositivos en lugar de depender de la nube.

- En lugar de hablar de plantillas y tecnología de IA, el énfasis en el producto de Apple significa que, por lo general, solo muestra nuevas características que la IA activa silenciosamente detrás de escena.

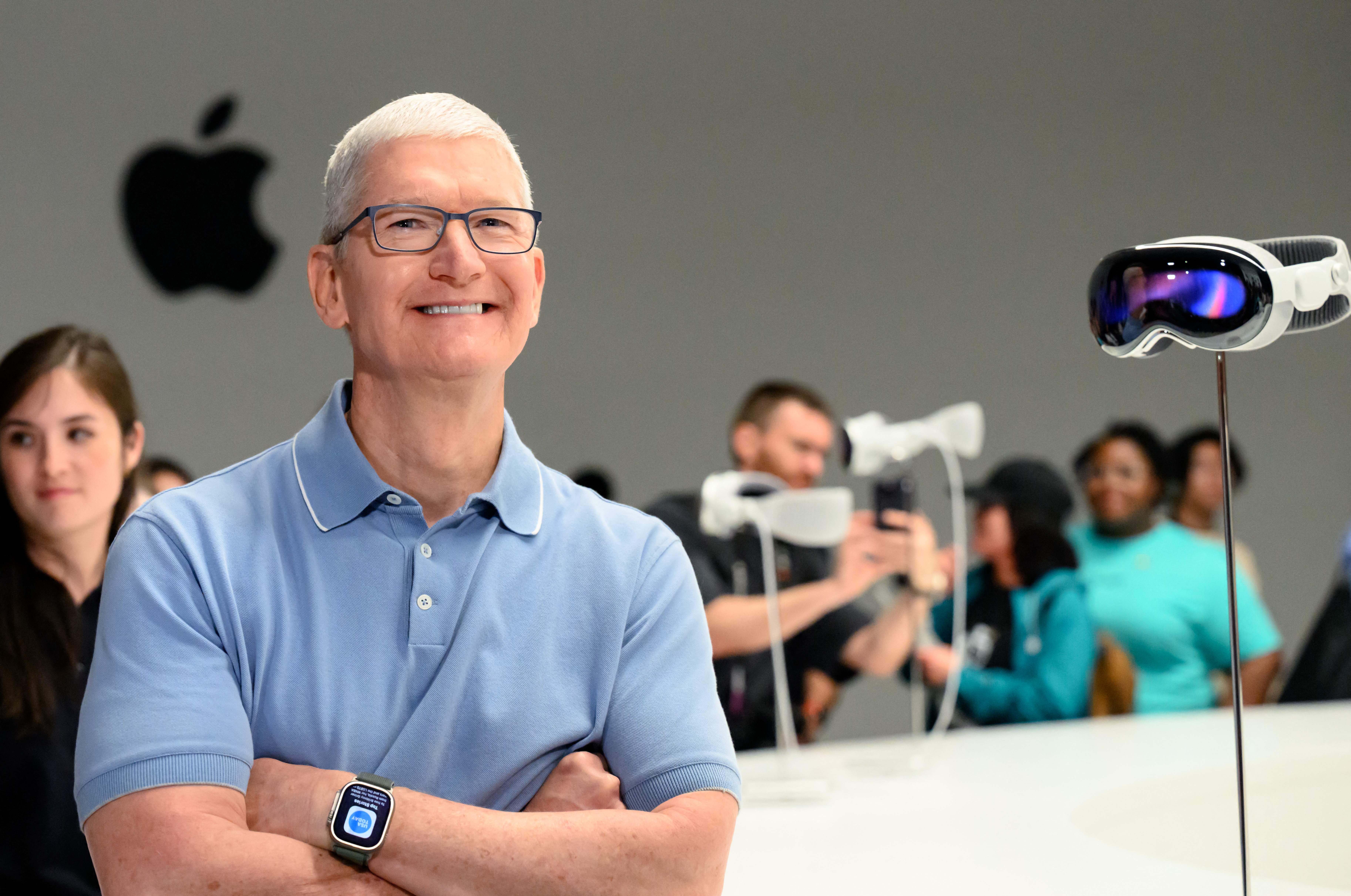

Apple Park se ve antes de la Conferencia Mundial de Desarrolladores (WWDC) en Cupertino, California, el 5 de junio de 2023.

Josh Edelson | AFP | imágenes falsas

El lunes, durante la conferencia anual de desarrolladores WWDC de Apple, la compañía reveló sutilmente cuánto trabajo está haciendo en inteligencia artificial y aprendizaje automático de próxima generación.

A medida que Microsoft, Google y nuevas empresas como OpenAI adoptaron tecnologías de aprendizaje automático de vanguardia como los chatbots y la IA generativa, Apple parecía estar al margen.

Pero el lunes, Apple anunció varias funciones importantes de inteligencia artificial, incluido un iPhone mejorado con autocorrección basado en un programa de aprendizaje automático que utiliza un modelo de lenguaje transformador, que es la misma tecnología que sustenta ChatGPT. Incluso aprenderá cómo escribe y escribe el usuario para mejorar, dijo Apple.

«Para esos momentos en los que solo desea escribir una palabra para evitar, bueno, el teclado también la aprenderá», dijo Craig Federighi, jefe de software de Apple, bromeando sobre la tendencia de autocorrección de usar la palabra sin sentido «evitar» para reemplazar una palabra común. palabra palabrota.

La noticia más importante del lunes fue su nuevo auricular de realidad aumentada, Vision Pro, pero Apple, no obstante, mostró cómo está funcionando y prestando atención a los desarrollos en el aprendizaje automático y la inteligencia artificial de próxima generación. ChatGPT de OpenAI puede haber llegado a más de 100 millones de usuarios en dos meses cuando se lanzó el año pasado, pero ahora Apple está usando la tecnología para mejorar una función que mil millones de propietarios de iPhone usan todos los días.

A diferencia de sus rivales, que están construyendo modelos más grandes con granjas de servidores, supercomputadoras y terabytes de datos, Apple quiere modelos de IA en sus dispositivos. La nueva función de autocorrección es particularmente impresionante porque se ejecuta en el iPhone, mientras que modelos como ChatGPT requieren cientos de costosas GPU trabajando en conjunto.

La IA en el dispositivo evita muchos de los problemas de privacidad de datos que enfrenta la IA basada en la nube. Cuando el modelo puede ejecutarse en un teléfono, Apple necesita recopilar menos datos para ejecutarlo.

También está estrechamente relacionado con el control de Apple sobre su pila de hardware, hasta sus propios chips de silicio. Apple agrega nuevos circuitos de IA y GPU a sus chips cada año, y su control de la arquitectura general le permite adaptarse a los cambios y nuevas técnicas.

A Apple no le gusta hablar de «inteligencia artificial», prefiere la frase más académica «aprendizaje automático» o simplemente habla de la capacidad que permite la tecnología.

Algunas de las otras empresas líderes de IA tienen líderes con antecedentes académicos. Esto ha llevado a un énfasis en mostrar su trabajo, explicar cómo puede mejorar en el futuro y documentarlo para que otros puedan estudiarlo y desarrollarlo.

Apple es una empresa de productos y ha sido muy reservada durante décadas. En lugar de hablar sobre el modelo de IA específico, los datos de entrenamiento o cómo podría mejorar en el futuro, Apple simplemente menciona la función y dice que hay una tecnología genial trabajando detrás de escena.

Un ejemplo de esto el lunes fue una mejora en los AirPods Pro que desactiva automáticamente la cancelación de ruido cuando el usuario inicia una conversación. Apple no lo ha presentado como una función de aprendizaje automático, pero es un problema difícil de resolver y la solución se basa en modelos de IA.

En una de las funciones más audaces anunciadas el lunes, la nueva función Digital Persona de Apple toma un escaneo 3D de la cara y el cuerpo de un usuario y puede recrear virtualmente su apariencia mientras realiza videoconferencias con otros usando los auriculares Vision Pro.

Apple también mencionó varias otras características nuevas que utilizaron la experiencia de la compañía en redes neuronales, como la capacidad de identificar campos para completar un PDF.

Uno de los mayores aplausos de la tarde en Cupertino fue una función de aprendizaje automático que permite que el iPhone identifique a su mascota, en comparación con otros perros o gatos, y coloque todas las fotos de mascotas del usuario en una carpeta.